Conductor – Google 的 Spec Coding

Conductor 是 Google 推出的一個 Gemini CLI 擴充套件,目前處於預覽階段,它透過「脈絡導向開發」(context-driven development)改變開發流程,讓開發者在編寫程式碼前先建立正式規格與計劃,並將其儲存為持久化的 Markdown 檔案。

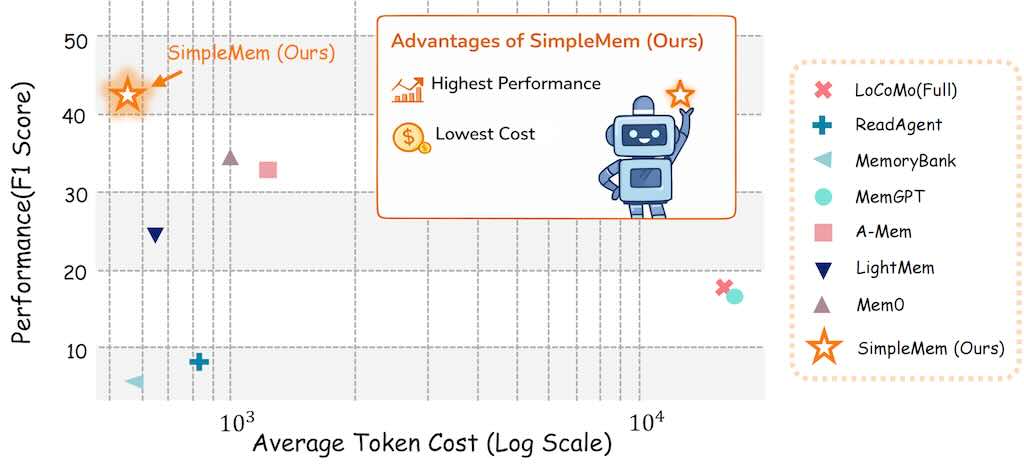

SimpleMem 高效終生記憶框架

端到端小型 LLM 微調教學

示範如何在本地使用 NVIDIA DGX Spark 或 Google Colab 微調 Google 的 Gemma 3 270M 模型,從資料準備到模型部署與 Gradio 示範。

Google Antigravity 在幾分鐘打造一個完整的 CRM

Google Antigravity 是 Google 推出的新一代 AI 原生 IDE,不是單純聊天寫程式,而是幫你「指揮一整個虛擬工程師團隊」。 在這支影片裡,創作者示範如何用 Antigravity 的 Agent Manager、規劃模式與多 agent 並行,在幾分鐘內從零打造一個完整的 CRM 工具,包含聯絡人、交易 pipeline 和任務管理。

透過 Artifacts,你可以像在 Google Docs 一樣對實作計畫、程式碼與螢幕截圖加註留言,人類負責決策與品管,AI 負責大量重工。 更酷的是,Antigravity 內建 Gemini 3 Pro、Claude Sonnet 4.5 和 GPT‑4,讓你可以把 UI 設計、後端架構與日常雜務分配給最擅長的模型來做。 再結合瀏覽器自動化與客製化 Workflow,你等於擁有一個會自己規劃、自己寫、自己測、還會跟你報告進度的超強開發夥伴,現在還是免費就能用的等級。

CoV 提升視覺語言的空間推理能力

CoV (Chain-of-View Prompting for Spatial Reasoning) 可以用於各種需要在複雜三維環境中進行精確空間理解的場景。例如 VR 和 AR,CoV 可以幫助系統更好地理解和響應用戶在虛擬環境中的查詢,提供更自然、更沉浸式的體驗。在自動駕駛領域,CoV 可以增強車輛對周圍環境的理解能力,提高其在複雜道路條件下的導航和決策能力。

CoV 提出一種創新方法,專門針對在三維環境中的具身問答(Embodied Question Answering, EQA)問題。傳統的視覺語言模型(Vision-Language Models, VLMs)受限於固定的輸入視角,這使得它們在推理過程中無法動態地獲取與問題相關的上下文信息,進而限制了複雜空間推理的能力。CoV 通過引入一種免訓練、僅在測試階段運行的框架來解決這一問題,該框架能夠讓 VLMs 變成主動的視角推理器。

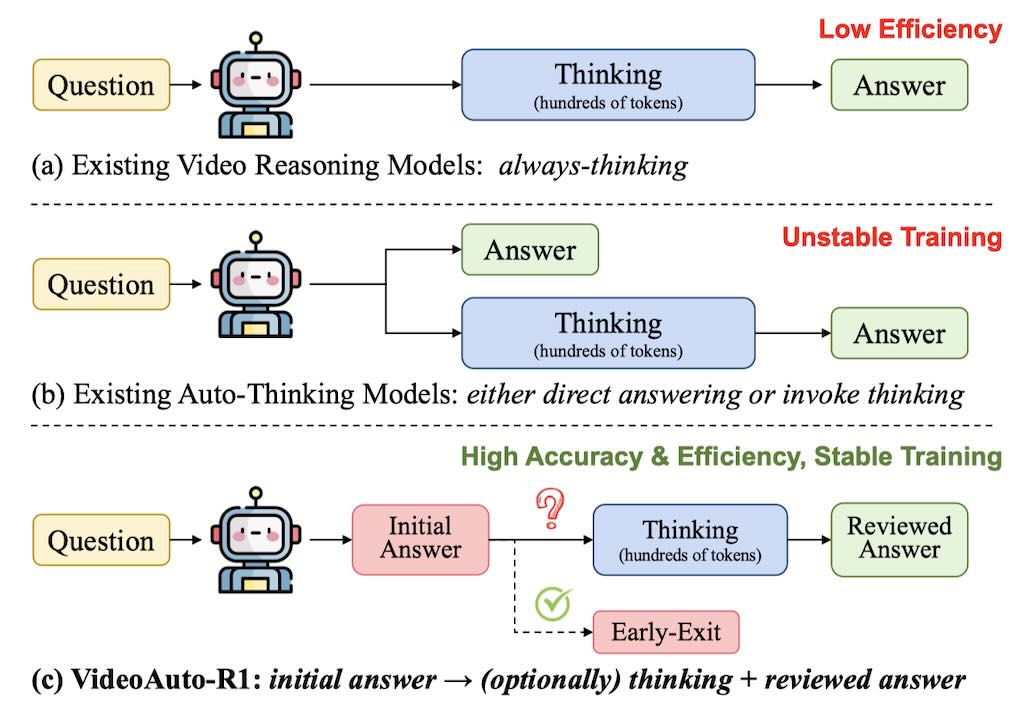

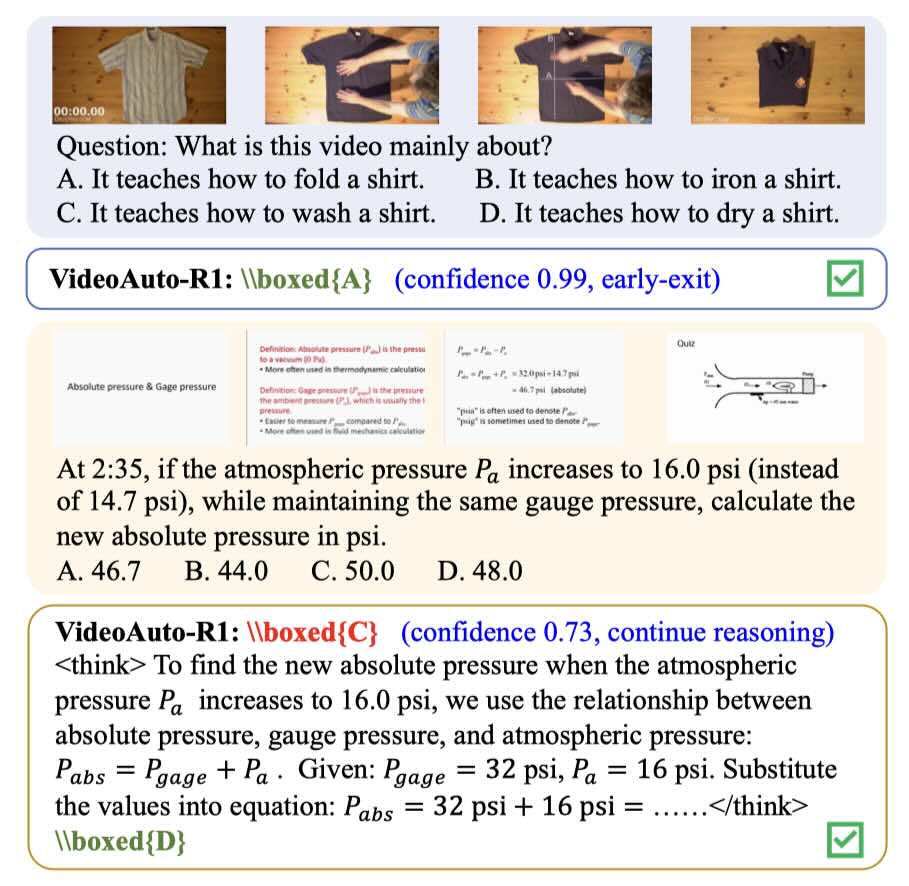

VideoAuto-R1 一次思考,兩次回答視頻推理

VideoAuto-R1 採用了一種「當需要時才推理」的策略。這種策略在訓練階段遵循「一次思考,兩次回答」的範式,即模型首先生成一個初步答案,然後進行推理,最後輸出一個經過審核的答案。這兩個答案都通過可驗的獎勵進行監督。在推理階段,模型使用初步答案的置信度分數來決定是否繼續進行推理過程。Meta 在 VideoAuto-R1 專案中扮演研究合作與工程貢獻角色。

1. 視頻問答系統:VideoAuto-R1 可以應用於各種視頻問答任務,提高系統在理解和回答視頻內容方面的準確性,同時降低計算成本。

2. 教育與培訓:在線教育平台可 leverage 這種技術來提供更智能的學習助手,幫助學生理解複雜的視頻內容,並根據需要提供針對性的解釋。

3. 互動式媒體:增強視頻內容的互動性,例如通過自動推理來回答用戶關於視頻內容的問題。

4. 智能監控:在安全監控系統中,VideoAuto-R1 可以用來分析和解釋監控視頻中的活動,從而提高安全性和監控效率。

5. 自動化客戶服務:在客服領域,該技術可以幫助自動化回答客戶關於產品或服務視頻的問題,提供更個性化的客戶體驗。

6. 內容創作與編輯:視頻創作者可以利用這種技術來自動化地生成視頻描述和解釋,從而簡化內容創作和編輯過程。

7. 多模態學習和研究:VideoAuto-R1 作為一種多模態理解技術,可以促進自然語言處理和電腦視覺領域的研究。

Qwen3-VL-Embedding-2B

「Qwen3-VL-Embedding-2B」是 Qwen 家族中最新的多模態信息檢索和交叉模態理解模型。可在同一向量空間做相似度計算,方便做「跨模態檢索」與「圖文混合檢索」。

Embedding 維度可控:預設最高 2048 維,但支援使用者自訂輸出維度 64–2048,可依儲存成本與下游模型需求調整(例如 256/512 維用於向量 DB)。

模型規模與 context length:2B 參數,context 長度 32k,適合放在邊緣或低資源伺服器上,同時能處理長文檔、多 frame 影片描述等輸入。

| 模型 | Gemini Multimodal Embeddings | Qwen3-VL-Embedding (2B/8B) |

|---|---|---|

| 模態支援 | 文字、圖片、video(含 audio 軌道,1 FPS + 音頻特徵) | 文字、圖片、截圖、video(多 frame),混合任意組合 |

| 語言 | 多語(英文主導) | 30+ 語言,強中文/多語對齊 |

| 維度 | 固定 1408 | 可自訂 64–4096(預設 2048) |

| Context | Video 上限 1-3 小時 | 32K tokens(長影片多 frame) |

| 開源 | 否(API) | 是(HF/GitHub,Apache 2.0) |

| 成本 | $0.0001/1000 chars(text),更高 video/image | 免費本地,GPU 硬體成本 |

| 整合 | Vertex AI / Gemini API,易 scale | Transformers/vLLM,量化友好 |

- 1. 圖像和文本檢索系統:可以用於基於文本描述搜索相關圖像,或者基於圖像內容搜索相關文本描述。

- 2. 視頻推薦平台:將視頻和文本描述映射到共享表示空間,以提高視頻推薦的準確性。

- 3. 多模態內容管理:對於包含圖像、文本和視頻的大型數據集,可以進行有效的內容聚類和組織。

- 4. 社交媒體分析:分析和理解跨文本和圖像的用戶生成內容。

- 5. 教育和培訓:藉助於視覺問答和多模態學習材料,提供個性化的學習體驗。

PlenopticDreamer – NVidia 解決影片一致性

PlenopticDreamer 主要解決「鏡頭控制生成影片」的不一致問題。這是一個能讓 AI「像無人機一樣繞著物體飛」生成影片的技術。它可以應用在自駕車的模擬環境、機器人的視覺訓練,以及好萊塢等級的虛擬拍攝。

1. Robotics(機器人):

* 情境模擬: 機器人需要理解物體在不同角度下的樣貌。這個技術可以根據單一攝影機的畫面,生成該物體在其他視角的影像,幫助機器人進行視覺導航或物體抓取的訓練。

* 模擬數據生成: 為機器視覺系統生成更多樣化的訓練數據。

2. Self-Driving(自駕車):

* 場景理解: 自駕車通常有多個鏡頭。這個技術可以補足盲區,或者將一個鏡頭的畫面轉換成其他鏡頭的視角,幫助車輛更全面地感知周圍環境。

* 未來幀預測: 預測道路上物體在下一秒鐘會出現在哪個位置(從不同角度)。

3. 影視製作與 AR/VR:

* 新視角補全: 如果拍攝時漏掉了某個角度,可以利用這個技術「憑空生成」該角度的連續影片。

* 重定向(Re-direction): 可以將拍好的影片,根據新的鏡頭軌跡重新渲染(Re-rendering),讓同一段故事可以從不同角度重新看一遍。

RoboVIP 訓練機器人的模擬數據生成

RoboVIP 解決機器人領域中,真實世界訓練數據不足且難以大量取得的痛點。RoboVIP 是一個機器人數據生成工具,它讓研究者能用更聰明、更可控的方式製造模擬數據,進而訓練出更強大、更不容易出錯的機器人。

RoboVIP 引入了「視覺身份提示 (Visual Identity Prompting)」,你可以直接給 AI 一張「參考圖」(例如一張特定碗的照片),AI 就能精準地在影片中生成或替換成那個碗,讓生成的畫面更真實、更符合需求。

研究證明,用 RoboVIP 處理過的數據去訓練機器人(像是 Pi0 或 Octo 這類模型),不只在模擬環境中表現更好,在真實世界的機器人操作上,成功率也顯著提升,尤其是在處理混亂、複雜的場景時。