Step3-VL-10B 是一款輕量級開源基礎模型,旨在重新定義緊湊高效與前沿多模態智能之間的權衡。儘管僅有 10B 參數,Step3-VL-10B 在視覺感知、複雜推理和人類對齊方面表現卓越。

該模型在 10B 規模以下的模型中始終表現最優,並能媲美甚至超越規模大 10×–20× 的開源模型(如 GLM-4.6V 106B-A12B、Qwen3-VL-Thinking 235B-A22B)以及頂級閉源旗艦模型(如 Gemini 2.5 Pro、Seed-1.5-VL)。

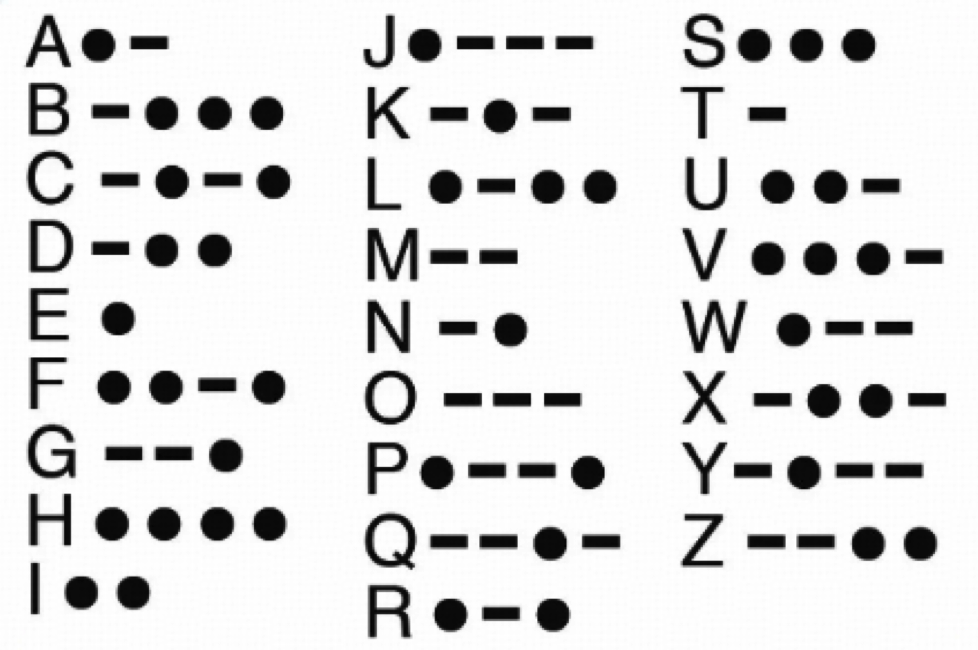

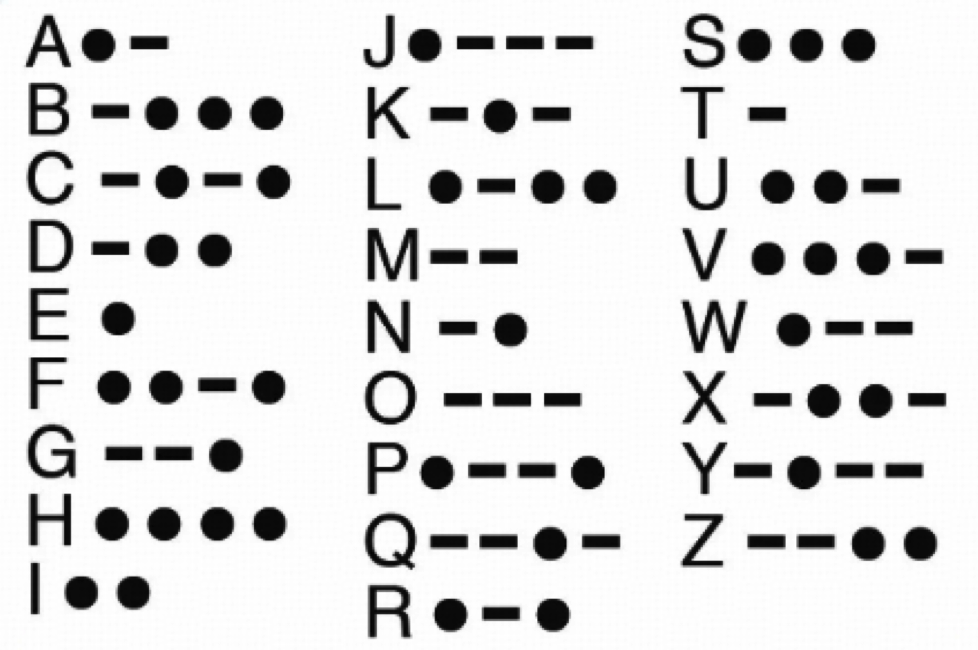

Demo: 根據表格推導”STEPFUN”的莫爾斯編碼

Thinking Process

用户现在需要把每个字母转换成莫尔斯电码,先看每个字母在表中的编码。首先分解"STEPFUN"每个字母:S、T、E、P、F、U、N。

S:看右边第三列第一个,S是···(三个点)。(一个短横)

T:第三列第二个,T是-。

E:左边第一列第五个,E是·(一个点)。

P:中间列(J到R)中P对应的符号是·--·点、短横、短横、点)。

F:最左侧列第六行,F的符号是··-·(两个点、一个短横、一个点)。

U:最右侧列第三行,U的符号是··-(两个点、一个短横)。

N:中间列(J到R)第五行,N的符号是-·一个短横、一个点)。

再将每个字母的编码按顺序拼接(字母间用空格分隔更清晰),"STEPFUN"的莫尔斯电码为:··· - · ·--· ··-· ··- -·

Final Answer

··· - · ·--· ··-· ··- -·

Step3-VL-10B 的成功源於兩大核心設計:高質量多模態語料庫的統一預訓練(1.2T tokens)與規模化多模態強化學習(超過 1,400 次 RL 迭代),並引入 Parallel Coordinated Reasoning (PaCoRe) 實現並行視覺探索的證據聚合。