用 ORPO 微調 Llama3

Categories: 教學

Inspectus 是一款適用於大型語言模型的多功能視覺化工具。它透過易於使用的 Python API 在 Jupyter 中流暢運行。 Inspectus 提供多種視圖,提供語言模型行為的不同見解。

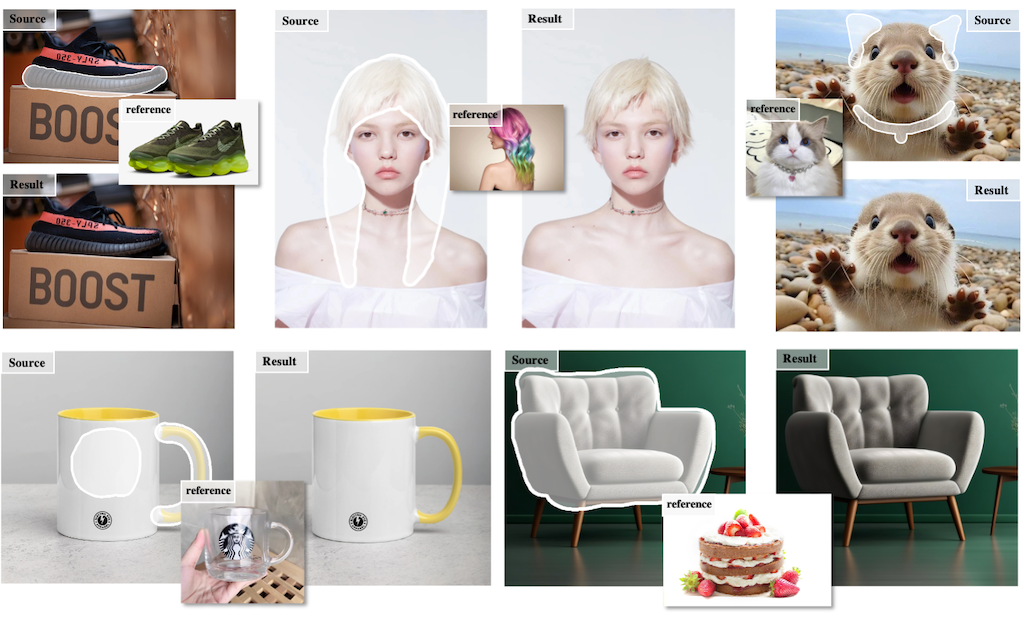

MimicBrush 的一種創新的圖像編輯方法,通過提供參考圖像來編輯圖片,而無需明確指定編輯的細節。MimicBrush 的核心思想是「模仿編輯」,只需在原始圖像中用 Brush 標記要編輯的區域,並提供一張參考圖片,模型就會自動理解參考圖像中與目標區域相關的語義,並將其應用於編輯。這種方法使用基於擴散模型的生成框架,通過從影片中隨機選取幀並遮罩部分區域來進行自行監督學習,使模型能夠捕捉不同圖像之間的語義關係,實現零樣本的圖像編輯。研究還提供了一個基準測試,旨在促進未來對此領域的研究。

進楷優化

微調前後