VChain 推理時間視覺思維鏈

近期的影片生成模型已能產生流暢且具視覺吸引力的影片片段,但在結合複雜動態與連貫的事件因果上仍然面臨挑戰。如何準確建模隨時間變化的視覺結果與狀態,依然是核心難題。

相對而言,大型語言與多模態模型(如 GPT-4o)展現出強大的視覺狀態推理與未來預測能力。為了結合這些優勢,VChain 是一種新穎的「推理時間視覺思維鏈」框架。VChain 將多模態模型的視覺推理信號,注入影片生成過程中,以增強生成模型的推理一致性。

具體而言,VChain 包含一個專用管線,利用大型多模態模型生成一組稀疏的關鍵幀作為事件快照,並在這些關鍵時刻指導預訓練影片生成器進行稀疏推理時間調整。這種設計使調整過程高效、開銷極低,且無需密集監督。

Paper2Video 論文自動生成視頻系統

Paper2Video 能從輸入的論文(LaTeX源碼)、一張圖片和一段音頻,生成完整的學術報告視頻。集成了幻燈片生成、字幕生成、游標定位、語音合成、講者視頻渲染等多模態子模塊,實現一條龍的演示視頻製作流程。支持並行處理以提升視頻生成效率,推薦GPU為NVIDIA A6000(48G顯存)及以上。

需要設定 GPT-4.1 或 Gemini2.5-Pro 等大型語言模型 API Key,支持本地 Qwen 模型。

Suno AI V5 專業音樂製作

Suno AI V5 is INSANE – Suno Studio, MIDI Stems, New Remaster, Hooks

musubi-tuner 影像微調 (LoRA)

musubi-tuner 提供使用 HunyuanVideo、Wan2.1/2.2、FramePack、FLUX.1 Kontext 和 Qwen-Image 架構訓練 LoRA(低秩自適應)模型的腳本。

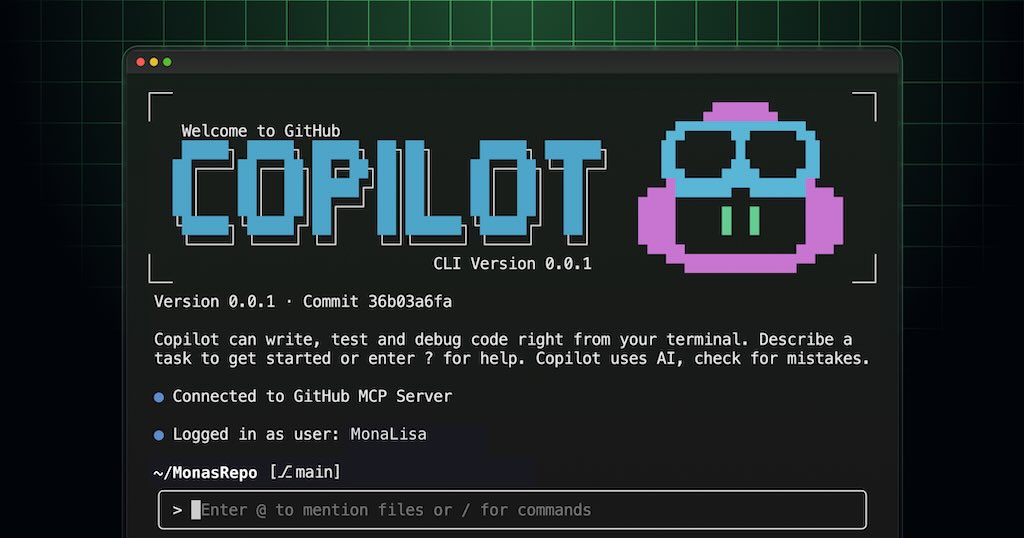

GitHub Copilot CLI 正式發佈

GitHub Copilot 編碼代理的強大功能直接帶到您的終端。透過 GitHub Copilot CLI,您可以在本地與能夠理解您的程式碼和 GitHub 上下文的 AI 代理程式同步工作。

Chrome MCP 伺服器

Chrome MCP 伺服器是一款基於 Chrome 擴充功能的

模型上下文協定 (MCP) 伺服器,它將您的 Chrome 瀏覽器功能開放給 Claude 等 AI 助手,從而實現複雜的瀏覽器自動化、內容分析和語義搜尋。與傳統的瀏覽器自動化工具(例如 Playwright)不同,

Chrome MCP 伺服器直接使用您日常使用的 Chrome 瀏覽器,利用現有的使用者習慣、配置和登入狀態,讓各種大型模型或聊天機器人控制您的瀏覽器,真正成為您的日常助理。

CWM 320 億參數 (32B) 的代碼推理模型

Wan-Animate:統一角色動畫及整體替換

Wan-Animate,一個用於角色動畫和替換的統一框架。給定一張角色圖像和一段參考視頻,Wan-Animate 可以透過精確複製視頻中角色的表情和動作來為角色製作動畫,從而產生高保真度的角色視頻。或者,它可以將動畫角色整合到參考影片中替換原始角色,複製場景的光線和色調,實現與環境的無縫融合。