影片主要在介紹幾個最新的生成影音工具與功能,包括 PixVerse R1 即時「世界模型」視頻、Flux 2 Klein 圖像模型、Runway 的 Story Panels、Google Veo 3.1 更新,以及開源的 Wonder Zoom 專案。

MoCha 成角色替換

MoCha 是一個專注於視頻角色替換的開源框架,旨在只需要單一參考即可完成角色替換,且不依賴任何結構化指導(如骨骼、深度圖或逐幀分割)。傳統的重建式方法往往必須提供完整的逐幀遮罩與額外的結構資訊,面對遮擋、複雜姿態或多角色互動時容易產生視覺雜訊與時間不穩定,而 MoCha 的設計則把這些限制全部排除,取而代之的是把不同條件統一為單一的 token 流,並通過條件感知的 RoPE(Rotary Positional Embedding)結合多參考圖像,支撐可變長度的影片生成。

DeekSeek mHC 改寫 AI 訓練及推理架構

3AM 分割影片中具有幾何的內容

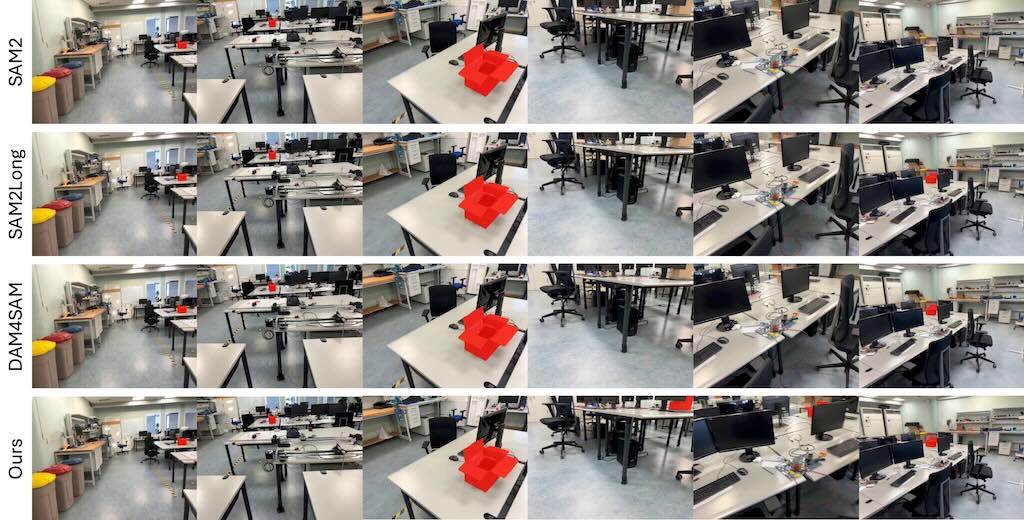

3AM 是一種結合了 2D 即時分割模型 SAM2 與 3D 幾何資訊的方法,目的是在影片或任意多視角圖像集合中,對同一物體保持一致的分割 mask。傳統的 2D 追蹤模型(如 SAM2)在觀點大幅變化時會因為只能依賴外觀特徵而失去目標,而早期的 3D 方法則需要提供相機位姿、深度圖或複雜的前處理,才能保證跨視角的一致性。

3AM 的創新在於在模型訓練階段,透過輕量的特徵合併模組把從 MUSt3R(一個多視角重建模型)學到的隱式幾何特徵與 SAM2 的外觀特徵結合,形成既能捕捉空間位置又能反映視覺相似度的表示。這樣的融合讓模型在推論時只需要原始 RGB 影像和使用者提供的提示(點、框、mask 等),就能在不同觀點之間追蹤物體,且不需要額外的相機資訊或前處理步驟。文章指出,這種做法在包含大量視角變化的基準測試集(如 ScanNet++、Replica)上,IoU 數值提升顯著,例如在 ScanNet++ 的 Selected Subset 上比 SAM2Long 高出約 15.9 個百分點。整體而言,3AM 在保持即時、可提示化的特性同時提升了跨視角的一致性,為後續的 3D 實例分割與多視角物體追蹤提供了一個更簡單、更有效的解方案。

Ministral 3 小模型家族

Ministral 3 是 Mistral AI 推出的模型系列,這是一系列參數高效的小型語言模型,專為計算和記憶體受限的應用而設計,提供三種模型規模:3B、8B 和 14B 參數。對於每種模型規模,我們都發布了三個變體:用於通用用途的預訓練基礎模型、指令微調模型以及用於解決複雜問題的推理模型。此外,我們還介紹了透過級聯蒸餾(Cascade Distillation)來產生 Ministral 3 模型的方法,這是一種迭代剪枝和持續訓練的蒸餾技術。每個模型都具備影像(OCR)理解功能,所有內容均遵循 Apache 2.0 授權。

NVidia Motive 影片動態框架

Motive 是個專門針對「動作/時間動態」的標記框架,用梯度 + motion 加權 mask,微調 clip 對生成影片 motion 的影響量化,拿來做 dataset curation,顯著提升 T2V 模型的時間一致性與物理合理性。據我們所知,這是第一個在影片生成模型中對運動而非視覺外觀進行歸因,並將其用於微調資料整理的框架。

這視覺模型能幫影片找出「哪個參考影片,真正決定它的動作怎麼動」,然後用這些資訊來挑更好的訓練素材,讓生成影片的動作更順、更合理。

Apple 與 Google 化敵為友,宣布達成為期多年的 AI 合作

Apple 和 Google 達成一項為期多年的合作。未來一代的 Apple Foundation Models(蘋果自家基礎模型)將建立在 Google 的 Gemini 模型與雲端技術之上。

這些模型將用來支援未來的 Apple Intelligence 功能,包括今年會上線的更個人化版 Siri。

AI 已經深度進入影視產業

AI 已經深度進入影視產業,包括腳本輔助、分鏡、配樂、剪接、去噪、Roto、魔術遮罩、背景生成、群眾演員替代、配音克隆與去老化特效等。

導演主張未來是「AI 和創作者」的混合模式,而不是二選一:AI 強化視覺與流程,人類負責情感、品味與敘事判斷。

真正的風險在於資方把 AI 當成「捷徑」來節省人力成本,壓縮藝術與勞動,而不是把它當作創作工具。

(more…)AlphaEvolve 無限智慧 – Google Deepmind

AlphaEvolve 無限智慧 – 讓 AI 自己做科學研究與演算法設計的系統 – Google Deepmind A.I.

NexaSDK 全模型支持,全硬件兼容

NexaSDK 是一個高性能的本地推理框架,可以在 NPU、GPU 和 CPU 上運行最新的多模態 AI 模型,支持 Android、Windows、Linux、macOS 和 iOS 設備。它只需幾行代碼,就能在設備上搭建最智能、最快的 AI 應用。NexaSDK 支持最新的模型,比如 Qwen3-VL、DeepSeek-OCR、Gemma3n 等,且比其他框架提前幾周或幾個月支持。。

使用 NexaSDK 建立真正的裝置端 AI 應用,將有獲得獎勵。(詳情)

另外,NexaSDK 還提供了一個簡單易用的命令列介面(CLI),讓使用者可以快速測試不同的模型。例如,你可以用一行指令就開始與 Qwen3 模型聊天,或者進行多模態任務,比如拖曳圖片到 CLI 裡進行處理。