https://jetpack.com/

Jetpack Social 而家可以自動將你嘅 WordPress 內容分享到 Instagram、Mastodon、Facebook、LinkedIn同Tumblr! Jetpack Social 提供咗便利嘅功能,可以喺你發佈新文章時,自動將該內容同步到多個社交媒體平台上。依家你唔駛一一登入每個平台嚟分享你嘅內容,節省咗寶貴嘅時間同精力。

經過 Jetpack Social 嘅設置,你可以輕鬆選擇你想同步分享嘅社交媒體平台。唔論你係想喺 Instagram 上分享靚相,定係喺 Facebook、LinkedIn同Tumblr 上分享嘅文章,Jetpack Social都可以幫到你。只需一次性嘅設置,之後你嘅內容會喺發佈時自動同步分享到所選嘅平台上。

Jetpack Social 唔止可以自動同步分享內容,亦都可以同步噏互動。如果你係一個網站管理員,Jetpack Social 可以幫助你喺多個社交媒體平台上回覆留言、讚好、分享和關注。呢個可以增加你同社區嘅互動,並提高你嘅網站嘅曝光度。

使用 Jetpack Social 係非常容易嘅,只需要安裝同啟用 Jetpack 插件,然後去 Jetpack 設定頁面設置社交媒體帳號同步。之後,你就可以享受自動分享到各社交媒體。

WordPress Jetpack AI 是一個由 Automattic 開發的 WordPress 擴充套件,提供強大的人工智能功能。它可以在 WordPress 網站中實現自動化內容生成和修改的能力。Jetpack AI 可以通過內置的AI助手,根據用戶的要求生成和修改內容,並提供豐富的工具和功能來增強網站的運營效果。

Jetpack AI 的功能非常多樣化,可以用於自動生成部落格文章、提供內容建議和優化、修稿和校對文本、編寫 SEO 優化的摘要和元描述等。它還能夠分析網站數據,提供關於訪問量和用戶行為的洞察,從而幫助用戶改進和優化網站內容。

使用 Jetpack AI 非常簡單,只需要在 WordPress 網站中安裝和啟用 Jetpack 擴充套件,然後在內容編輯器中添加 Jetpack AI 區塊,即可開始使用相關的功能。Jetpack AI 的使用使得網站內容的生成和修改更加高效和準確,同時還能夠節省用戶的時間和精力。

如何使用 Jetpack AI

Jetpack AI 是一個強大的人工智能助手,可以幫助您編寫內容、翻譯文字、生成摘要,以及提供自動修改和建議等功能。以下是使用 Jetpack AI 的幾個步驟:

- 安裝 Jetpack AI:首先,確保您已在 WordPress 上安裝並啟用 Jetpack 插件。然後,訪問您的 WordPress 網站後台,點選「Jetpack」並點擊「設定」。

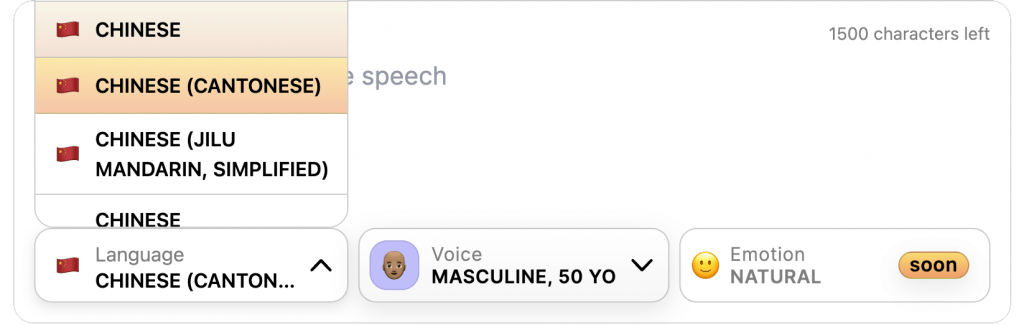

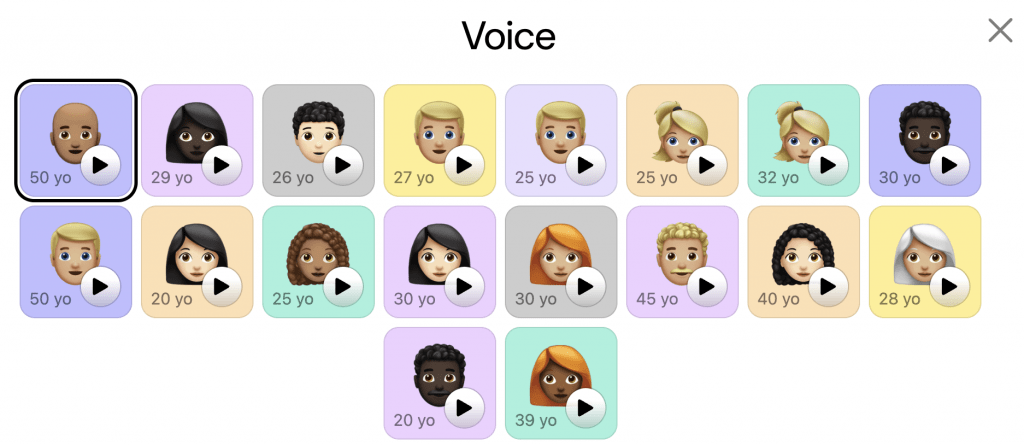

- 設定語言:在 Jetpack 設定頁面上,您可以設定 Jetpack AI 的語言。請選擇 “繁體廣東話” 以開始使用這種語言的功能。

- 使用 AI 功能:Jetpack AI 集成在 WordPress 編輯器中,您可以在撰寫文章或頁面時使用它。在您的 WordPress 編輯器中,點擊「添加區塊」按鈕,然後在搜索欄中輸入 “Jetpack AI”。選擇該區塊後,您將看到 Jetpack AI 的界面。

- 提出請求:在 Jetpack AI 的界面上,您可以輸入您的請求或內容需求。請按下「執行」按鈕,Jetpack AI 將根據您的要求生成相應的內容。

- 獲取結果:Jetpack AI 會在右側面板中顯示生成的內容,您可以自由修改或使用該內容。同時,您也

* 對唔住,我講到一半無意識地用左普通話,我喺廣東話再繼續介紹多少少。(Jetpack AI)

- 獲取結果:Jetpack AI會喺右邊嘅欄度顯示生成嘅內容。你可以將呢個生成嘅內容直接插入你嘅文章或者頁面中,或者根據需要修改同調整。

Jetpack AI 非常強大,可以幫助你節省時間同改善你嘅內容。希望呢個簡單嘅介紹可以幫到你!如果你有任何問題,歡迎隨時向我提問。

如果您想要提高網站內容的質量和效率,我們強烈推薦您使用 WordPress Jetpack AI。詳細了解 Jetpack AI,請訪問https://jetpack.com/。