檢索增強生成流程中融合 HyDE

在 RAG(檢索增強生成,Retrieval-Augmented Generation)流程中融合 HyDE 技術,特別是在社交群組 AI 助理的應用場景。影片詳細說明了 RAG 的基本原理、技術演進、現實挑戰,以及 HyDE 方法如何解決多輪群聊語意檢索問題、具體提升個人化推薦的效果。

- 語意密度失衡:單一查詢若囊括多個主題(如運動、用餐、過敏),其向量可能遠離相關用餐記錄,導致錯誤檢索。HyDE 協助切分查詢語意,生成能精準接近真正目標向量的候選,提升召回率。

- 模型選型與延遲:現成 embedding 模型雖然容易部署,但當候選文檔增加,模型必須在準確率、延遲、用戶體驗之間平衡(過多候選會加劇延遲及降低內容相關性)。

- Tone Matching:HyDE 生成的假想對話需盡量貼近用戶原始語境;目前主流 embedding 更偏向語意,語氣風格次要,但理想設計仍會嘗試符合真實對話氛圍。

這案例對 RAG 技術實戰落地非常有啟發,尤其在社群、記憶建構、個人化需求場景的處理方式。若你有自己的群聊 AI 專案,這種查詢增強流程、高維語意檢索建議、如何平衡效率與準確,是值得深入借鑑的。

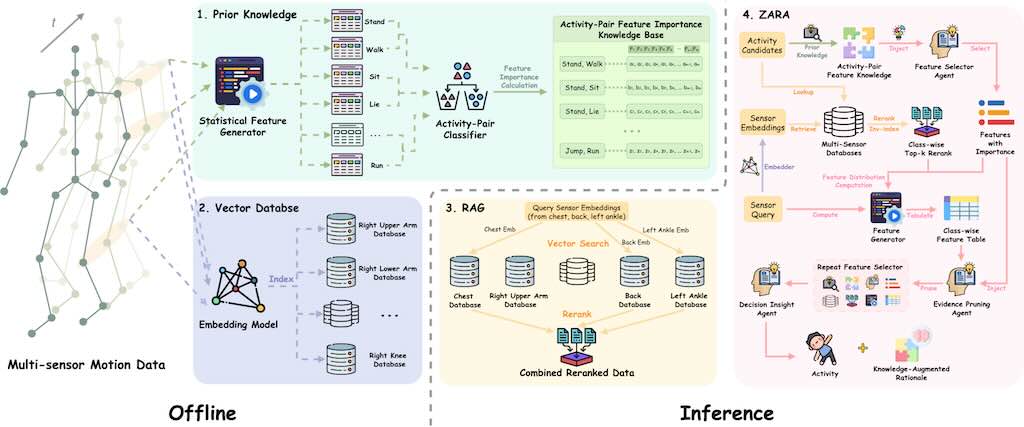

ZARA 人類身體活動識別框架

ZARA 是一個用於人類身體活動識別 (HAR Human Activity Recognition) 的新型框架,它利用穿戴式感測器的原始運動數據。傳統的 HAR 系統通常需要針對特定任務的深度學習模型進行昂貴的重新訓練,而且在引入新感測器或未見活動時,其泛化能力和零樣本識別能力有限,同時也缺乏可解釋性。

ZARA 透過結合多感測器檢索增強生成 (RAG)、自動化的成對領域知識注入和層次代理式大型語言模型 (LLM) 推理來克服這些限制。ZARA 不需額外訓練,就能在多種數據集和感測器配置上實現零樣本分類,其性能超越現有方法,並可提供驗證。研究強調了其檢索、知識庫和代理模組在提升準確性和支援決策方面的關鍵作用。

用 Python 構建 RAG 的每個細節

從零寫AI RAG 個人知識庫

影片中,作者使用了 Google 的 embedding 模型和 ChromaDB 向量資料庫來實現這個架構。

- RAG 架構簡介 解釋了 RAG 的基本原理,即將長文章拆分成小片段,對每個片段進行 embedding,然後儲存到向量資料庫中,並在使用者提問時找出最相關的片段發送給大型語言模型。

- 文章分塊 示範如何將一篇關於「令狐沖轉生為史萊姆」的虛構文章進行分塊處理。他首先使用雙回車符作為切分依據,然後進一步優化,將以警號開頭的標題與後續的正文合併。

- Embedding 與資料庫儲存 介紹如何使用 Google 的 embedding 模型對分塊後的文本進行 embedding,並將這些 embedding 及其原始文本儲存到 ChromaDB 向量資料庫中。作者特別提到 Google embedding 模型的「儲存」和「查詢」兩種模式。

- 查詢功能 說明如何透過查詢 embedding 模型並從 ChromaDB 中檢索出與使用者問題最相關的文本片段。

- 整合大型語言模型 最後,展示如何將查詢到的相關文本片段與使用者問題一起發送給大型語言模型(Gemini Flash 2.5),以生成更準確的回應。

影片強調動手實作的重要性,鼓勵觀眾親自寫一遍程式碼以加深理解。

RAG 智能升級

影片介紹如何用 LangGraph、Agentic RAG、Nano-GraphRAG 和 Claude 3.7 Sonnet 製作一個具備推理能力的代理 Agent。作者透過展示了使用不同的工具,令 AI 模型能夠使用計算機、字典和搜尋引擎來增強 AI 模型的能力。

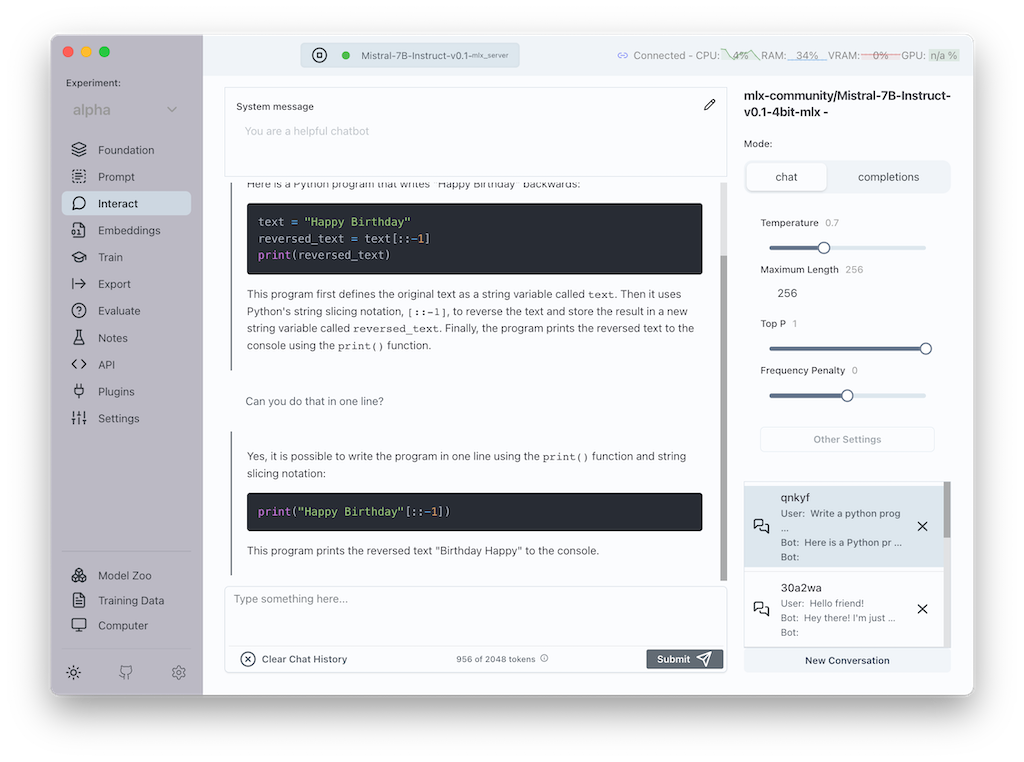

Transformer Lab 桌面 LLM 工作台

Transformer Lab 是個免費的開源 LLM 工作平台,方便進行微調、評估、匯出和測試,並支援唔同的推理引擎和平台。Transformer Lab 適用於擁有 GPU 或 TPU 的電腦,亦支援 MLX 的 M 系列的蘋果電腦。主要功能包括下載開源模型、智能聊天、計算嵌入、創建和下載訓練數據集、微調和訓練 LLM、以及使用 R A G 與文件互動。

![]()

以 Gradio 本地運行 RAG DeepSeek R1

影片教你如何建立一個簡單的 Web 應用程式,使用 Ollama LangChain 和 Gradio,透過檢索增強生成 (RAG) 來查詢 PDF 文件。無論你是 AI 的初學者或已有經驗,只要有興趣用 Web 運行 AI 模型,這教學都非常實用。由於支持離線運作,因此能夠增加安全性,保障私隱,特別是對於使用 AI 處理公司內部文件嘅任務。

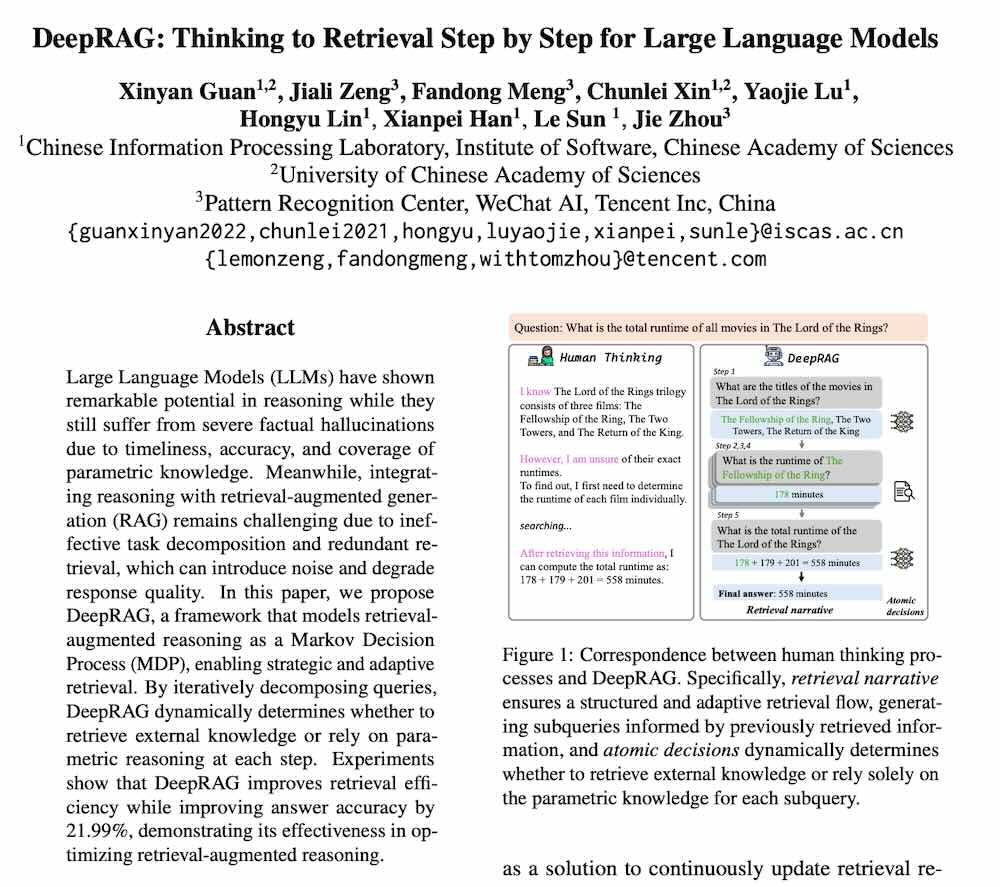

DeepRAG 思考式檢索增強生成

實作 Gemini 實時語音 RAG 助手。

利用 Gemini 2.0 的多模態即時 API 來建立一個實時的語音 RAG 助手。RAG,也就是檢索增強生成,肯定是語言模型中最有價值的增強之一。透過上下文感知的回答,它被證明是處理有關最新資訊的問題或任務的有效方法。

由於 Gemini 的多模態即時 API 裡面沒有內建的文件檢索介面,影片將展示如何建立一個自訂的流程,來接收用戶的語音,從提供的文件中檢索內容,然後讓Gemini 以語音回覆。