在訓練大型語言模型有多燒錢?一文學到:標榜最有台灣味的 Taiwan-LLM 語言模型,是以 Meta LLaMA 2 為基礎的全參數微調模型,大幅提升繁體中文能力並融入台灣文化。

可靠、完全本地化的 RAG 代理與 LLaMA3

隨著 LLaMA3 的發布,人們對能夠在本地可靠運行(例如,在筆記型電腦上)的代理產生了濃厚的興趣。在這裡,我們展示如何使用 LangGraph 和 LLaMA3-8b 從頭開始建立可靠的本地代理。我們將 3 篇高級 RAG 論文(Adaptive RAG、Corritive RAG 和 Self-RAG)的想法結合到一個控制流程中。我們在本地使用本地向量儲存 c/o @nomic_ai 和 @trychroma、用於網路搜尋的 @tavilyai 以及透過 @ollama 運行 LLaMA3-8b。

Ollama 向量嵌入模型

Embedding models 是一種專門用於生成向量嵌入的模型:長數組數字,代表給定文本序列的語義含義。生成的向量嵌入數組然後可以存儲在數據庫中,該數據庫將它們作為一種方式進行比較,以搜索具有相似含義的數據。

Embedding models 的工作原理是將文本分解為單詞或短語序列,然後為每個單詞或短語分配一個向量。這些向量通常是高維的,可以捕獲單詞或短語的語義含義。例如,單詞“國王”和“女王”可能具有相似的向量,因為它們都與皇室有關。

Embedding models 有許多應用,包括:

- 自然語言處理 (NLP):Embedding models 可用於提高 NLP 任務的性能,例如機器翻譯、文本分類和情感分析。

- 信息檢索 (IR):Embedding models 可用於提高 IR 系統的性能,例如搜索引擎和推薦系統。

- 計算機視覺 (CV):Embedding models 可用於將圖像表示為向量,這可以提高 CV 任務的性能,例如圖像分類和對象檢測。

Embedding models 是一種強大的工具,可用於提高各種任務的性能。它們是 NLP、IR 和 CV 等領域的重要研究領域。

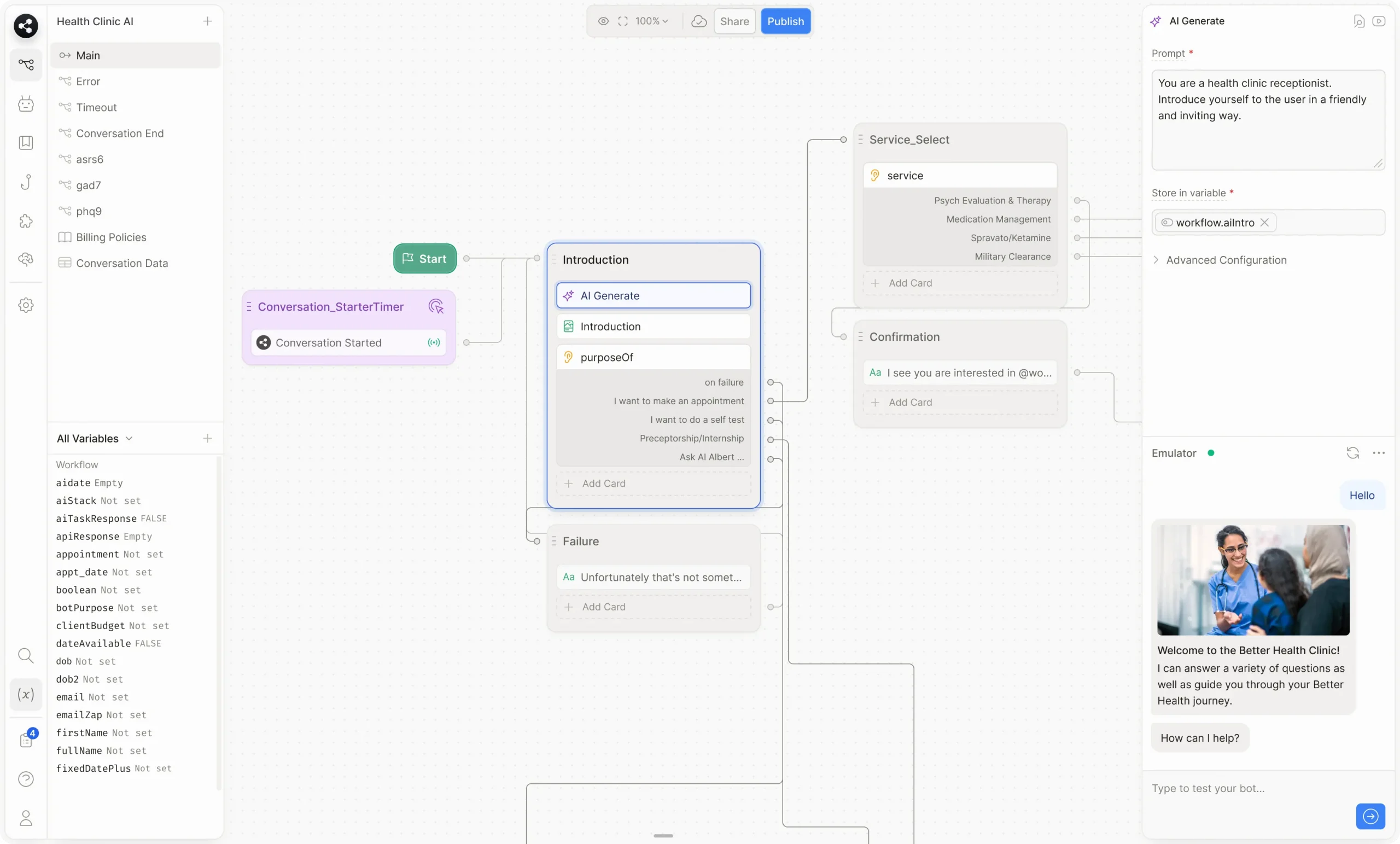

Botpress – ChatGPT 聊天機器人 AI 平台

Rivet 強大的整合開發環境 (IDE) 和函式庫

Rivet 是一個功能強大的整合開發環境 (IDE) 和函式庫,旨在使用基於圖形的視覺化介面建立 AI 代理程式。本指南將為您概述 Rivet 的功能,並引導您了解其各種特性和功能。

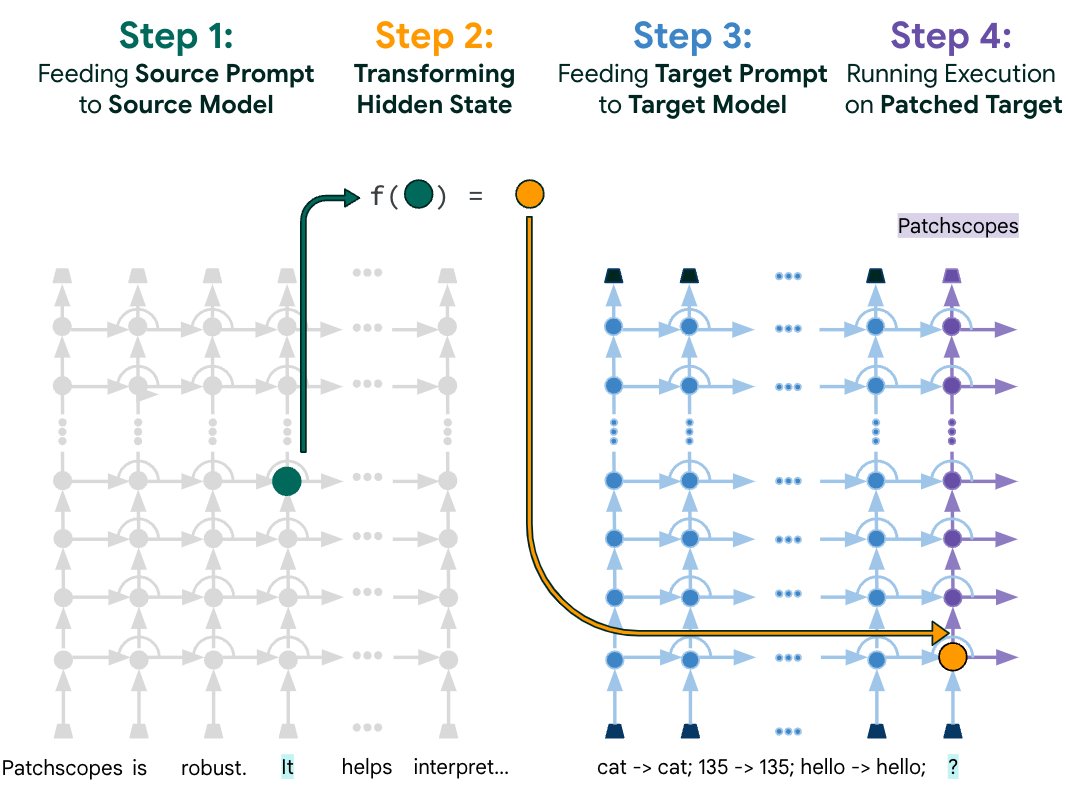

Patchscopes – Google 的自然語言統一框架

Patchscopes 是由 Google AI 研究人員提出的一個統一框架,用於以自然語言檢查大型語言模型 (LLM) 的隱藏表示。它利用 LLM 自身的能力來解釋其內部表示,並解決了先前解釋性方法的許多缺點。

Patchscopes 的工作原理是將來自源提示的表示“修補”到目標提示的推理過程中的特定層中。源提示旨在引導 LLM 執行要檢查的計算,而目標提示旨在鼓勵提取該計算的結果。例如,要檢查 LLM 如何表示“首席執行官”這個詞,可以將表示“首席執行官”的表示修補到目標提示中的“?”令牌上,並觀察 LLM 生成什麼輸出。

Patchscopes 具有以下優點:

- 它可以統一許多先前解釋性方法,並克服了這些方法的許多缺點。

- 它可以檢查 LLM 的早期層,這些層通常難以用其他方法檢查。

- 它具有很強的表達力,可以針對各種問題進行定制。

Patchscopes 已被用於回答有關 LLM 的各種問題,包括:

- LLM 如何表示單詞和短語?

- LLM 如何進行推理?

- LLM 如何生成文本?

- LLM 如何受到偏見的影響?

Patchscopes 是一個強大的工具,可用於解釋 LLM 的行為並提高其透明度。它有可能在 LLM 的開發和應用中發揮重要作用。

以下是一些關於 Patchscopes 的其他資源:

- Patchscopes: A Unifying Framework for Inspecting Hidden Representations of Language Models

- Patchscopes: A Unifying Framework for Inspecting Hidden Representations of Language Models – YouTube

- Patchscopes – People + AI Research

- @gsarti on Hugging Face: ” Today’s pick in Interpretability & Analysis of LMs: Patchscopes: A…”

比較LlamaIndex 與 LangChain (AI) 框架

未來的神經網絡訓練:超參數擴展 μ-Transfer

統一神經網絡設計與範疇理論

在深度學習中,設計神經網路架構的統一框架一直是個挑戰,也是最近研究的焦點。早期的模型是透過它們必須滿足的約束或它們執行的操作順序來描述的。這種雙重方法雖然有用,但缺乏一個有凝聚力的框架來無縫整合這兩種觀點。

研究人員解決了缺乏能夠解決約束規範及其在神經網路模型中實現的通用框架的核心問題。他們強調,目前的方法,包括關注模型約束的自上而下的方法和詳細說明操作序列的自下而上的方法,無法提供神經網路架構設計的整體視圖。這種脫節的方法限制了開發人員針對他們處理的獨特資料結構設計高效且客製化的模型的能力。

來自 Symbolic AI、愛丁堡大學、Google DeepMind 和劍橋大學的研究人員介紹了一種理論框架,該框架透過在 2 類參數映射中評估的單子將約束規範與其實現結合起來。他們提出了一種基於範疇論的解決方案,旨在為神經網路設計創建一種更整合和連貫的方法。這種創新方法概括了神經網路設計的多樣性,包括循環神經網路(RNN),並提供了理解和開發深度學習架構的新視角。透過應用範疇論,該研究捕捉了幾何深度學習 (GDL) 中使用的約束,並擴展到更廣泛的神經網路架構。

所提出的框架的有效性透過其恢復 GDL 中使用的約束的能力得到強調,展示了其作為深度學習通用框架的潛力。 GDL 使用群論視角來描述神經層,透過保持對稱性在各種應用中展現了前景。然而,當面對複雜的資料結構時,它會遇到限制。基於範疇論的方法克服了這些限制,並提供了一種用於實現不同神經網路架構的結構化方法。

這項研究的中心正在應用範疇論來理解和創建神經網路架構。這種方法可以創建與其處理的資料結構更緊密結合的神經網絡,從而提高這些模型的效率和有效性。該研究強調了範疇論作為神經網路設計工具的普遍性和靈活性,為神經網路模型中約束和操作的整合提供了新的見解。

總之,本研究引入了一個基於類別論的突破性框架,用於設計神經網路架構。透過彌合約束規範與其實現之間的差距,該框架提供了一種全面的神經網路設計方法。範疇論的應用不僅恢復並擴展了 GDL 等框架中使用的約束,也為開發複雜的神經網路架構開闢了新的途徑。

如何使用 LangChain 構建 LLM – 初學指南