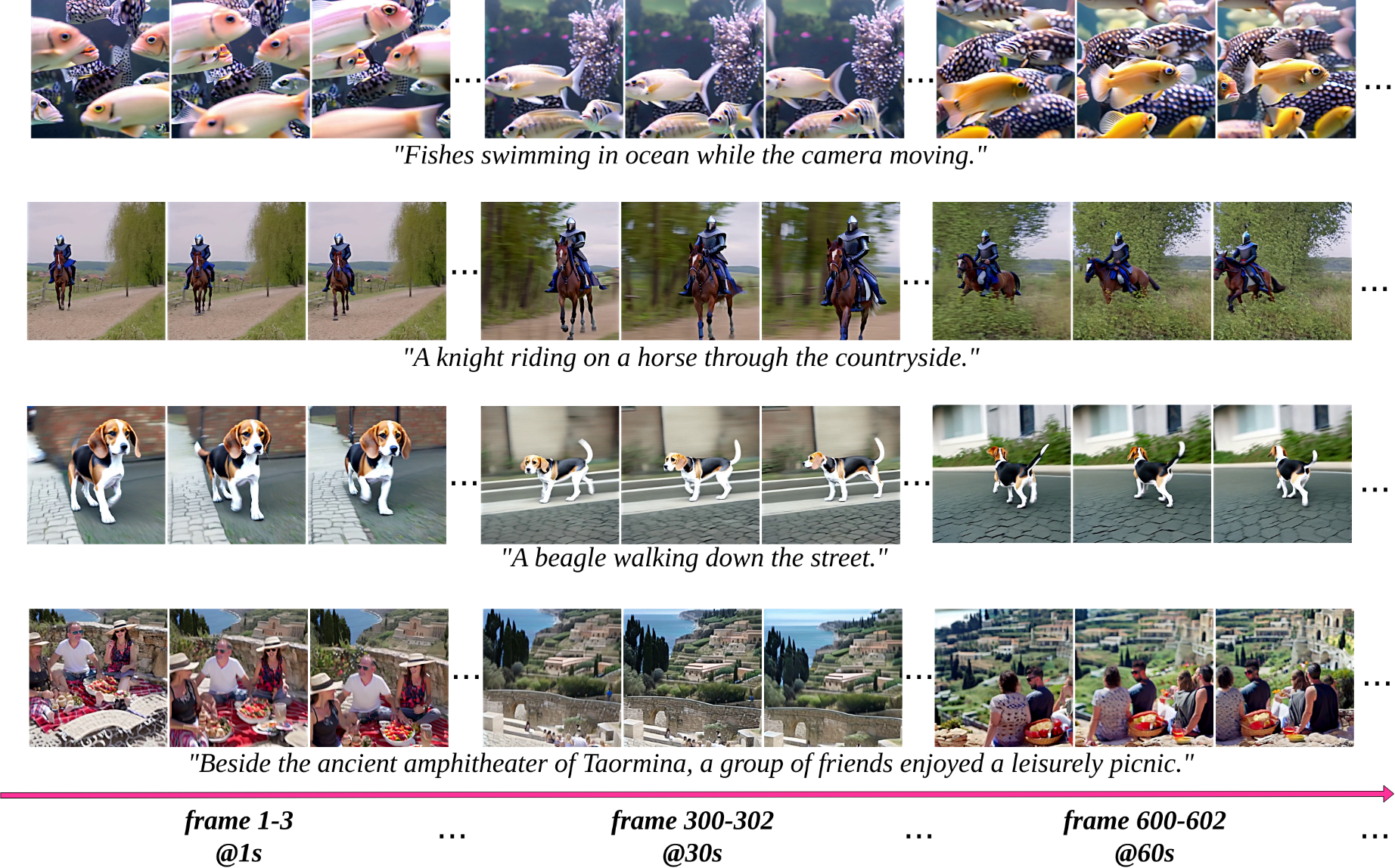

實測效果

Noisee AI 是一個允許用戶從他們最喜歡的旋律創建音樂視頻的程序。該網站包括一個博客,其中包含有關如何使用 Noisee 的文章,並展示了其他用戶創建的內容。

以下是一些 Noisee AI 的主要功能:

- 從旋律創建音樂視頻: 您可以上傳旋律或輸入 MIDI 文件,Noisee AI 將為您創建一個音樂視頻。

- 多種風格可供選擇: 您可以從多種風格中進行選擇,包括流行、搖滾、電子和爵士。

- 自定義選項: 您可以自定義視頻的外觀和感覺,包括顏色、文字和效果。

- 分享您的作品: 您可以將您的作品分享到社交媒體或下載到您的計算機。

Noisee AI 是一個創建引人入勝的音樂視頻的絕佳工具。它易於使用且功能豐富,因此您可以輕鬆創建令人驚嘆的視頻。

以下是一些使用 Noisee AI 的示例:

- 您可以使用 Noisee AI 為您的原創歌曲創建音樂視頻。

- 您可以使用 Noisee AI 為您最喜歡的歌曲創建音樂視頻。

- 您可以使用 Noisee AI 為您的學校或企業項目創建音樂視頻。

- 您可以使用 Noisee AI 僅僅出於樂趣而創建音樂視頻。

如果您有興趣了解有關 Noisee AI 的更多信息,請訪問其網站