近期的影片生成模型已能產生流暢且具視覺吸引力的影片片段,但在結合複雜動態與連貫的事件因果上仍然面臨挑戰。如何準確建模隨時間變化的視覺結果與狀態,依然是核心難題。

相對而言,大型語言與多模態模型(如 GPT-4o)展現出強大的視覺狀態推理與未來預測能力。為了結合這些優勢,VChain 是一種新穎的「推理時間視覺思維鏈」框架。VChain 將多模態模型的視覺推理信號,注入影片生成過程中,以增強生成模型的推理一致性。

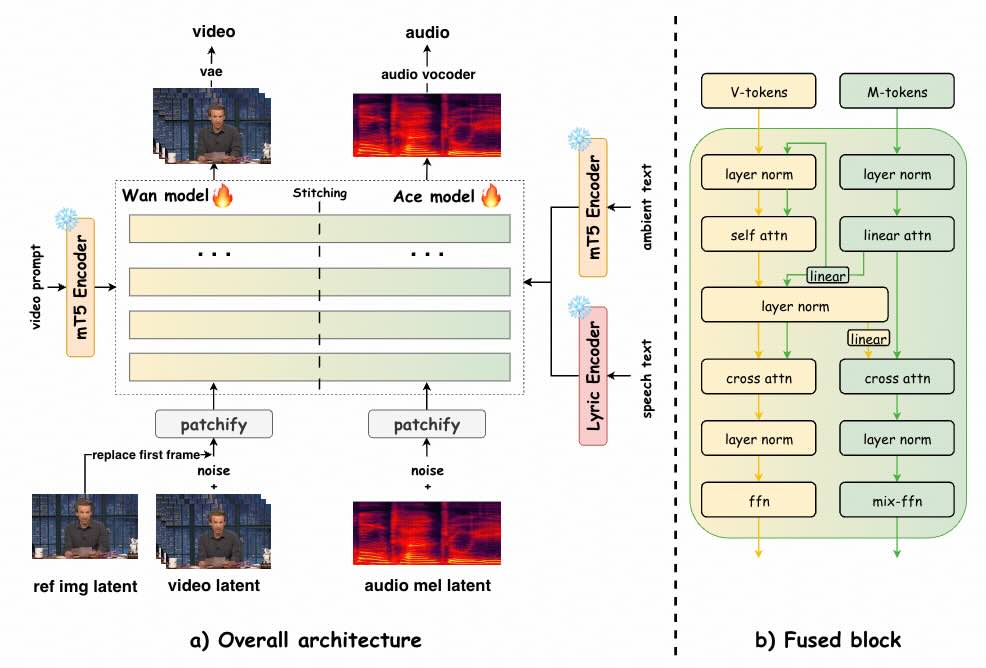

具體而言,VChain 包含一個專用管線,利用大型多模態模型生成一組稀疏的關鍵幀作為事件快照,並在這些關鍵時刻指導預訓練影片生成器進行稀疏推理時間調整。這種設計使調整過程高效、開銷極低,且無需密集監督。