💥 FaceFusion 3.2.0 更新不僅帶來了全新的GPU加速,還提升了不少效能與真實感!

🔍 新功能

1️⃣ YOLO NSFW過濾

2️⃣ 多GPU支援

3️⃣ FLAC音訊輸出

4️⃣ 臉部選擇增強

💥 FaceFusion 3.2.0 更新不僅帶來了全新的GPU加速,還提升了不少效能與真實感!

🔍 新功能

1️⃣ YOLO NSFW過濾

2️⃣ 多GPU支援

3️⃣ FLAC音訊輸出

4️⃣ 臉部選擇增強

LTX-Video 是第一個基於 DiT 的視訊生成模型,可以即時產生高品質的視訊。它可以以 1216×704 的分辨率生成 30 FPS 的視頻,比觀看這些視頻的速度還快。該模型在多樣化影片的大規模資料集上進行訓練,可以產生具有逼真和多樣化內容的高解析度影片。模型支援文字轉圖像、圖像轉影片、基於關鍵影格的動畫、影片擴充(正向和反向)、影片轉影片以及這些功能的任意組合。

Skywork 是一個創新的研究團隊,致力於推動法學碩士和多模式理解。它們的使命是透過視覺和語言開發並實現無縫互動的尖端模型和資料集來突破人工智慧的界限。模型支援文字到視訊(T2V) 和圖像到視訊(I2V) 任務,並且可以在同步和非同步模式下進行推理。

影片長度限制的突破:雖然像 LTXV 和 HuanYun 等模型在速度或品質方面表現出色,但它們通常限制生成約 5 到 10 秒的短片。Frame pack 可以生成高達 60 秒的高品質影片,但 60 秒是其最大長度。Skyreels V2 透過其稱為「擴散強制 (diffusion forcing)」的技術,可以讓您生成長達 60 秒甚至可能更長的影片。技術上,擴散強制模型可以透過不斷訓練一個擴散強制取樣器並在最後組合每個結果來無限延長影片長度。

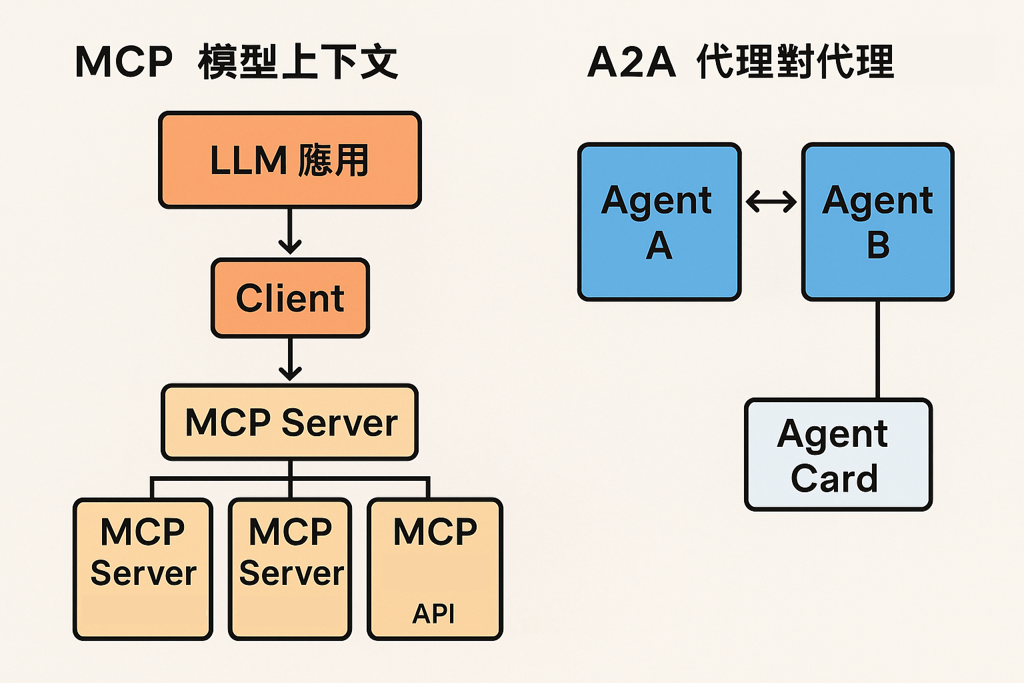

MiniMax 模型上下文協定 (MCP) 伺服器,可與強大的文字轉語音和視訊/圖像生成 API 進行互動。此伺服器允許 MCP 用戶端(如 Claude Desktop 、 Cursor 、 Windsurf 、 OpenAI Agents 等)產生語音、複製聲音、產生視訊、產生影像等。

GitHub MCP 伺服器是一個模型上下文協定 (MCP) 提供與 GitHub API 無縫整合的伺服器,為開發人員和工具提供自動化和互動功能。提供一鍵安裝。完成後,切換代理模式,伺服器將會自動啟動。

FramePack 是一種新的視頻擴散設計,用壓縮上下文令工作量不會隨著影片的長度而增加,只需一張圖片,就可以令你的 6GB vRAM 的電腦透過 13B 模型生成每秒 30 格影片的 60 秒影片。而用 RTX 4090 的話,最快速度為每格 1.5 秒。

作者 Lvmin Zhang

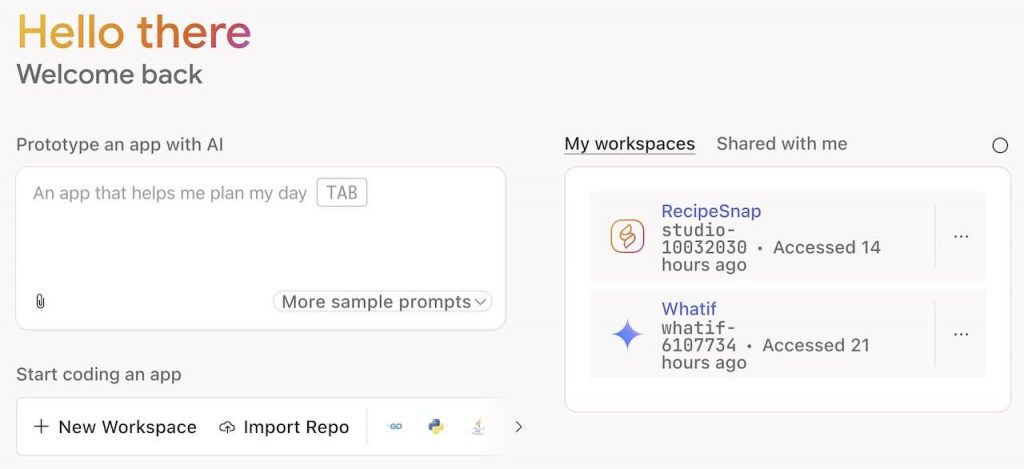

Google Firebase Studio 的目標是盡量簡化開發流程,就算你是剛剛開始學寫 App 也不用擔心。只要你有基本了解,Firebase Studio 可以透過 AI 助手 Gemini 幫你寫 Code、Debug 同埋改善效能。完成了之後,無論是全方位的應用程式,抑或 API、後台、前端同埋手機 App,佢都可以幫你自動整合發佈。測試期間,你可以擁有 3 個的免費工作空間。

影片展示了 Visual Studio 的最新 AI 功能,重點介紹了新的 Agent 智能體代理模式,同時引入了模型上下文協議 MCP Model Context Protocol。影片亦示範了完整的應用程式開發,並通過不同的模式與 AI 進行交互:包括詢問,編輯。亦會根據項目要求自動進行修改。這些進步反映了 AI 技術在增強開發工作流程和提高效率方面的快速成長。