涵蓋 DeepSeek-R1及其衍生模型(例如R10、R1Z)的全面介紹,包含安裝設定、效能基準測試(與OpenAI模型相比),以及各種硬體環境下的除錯和最佳化方法。課程重點在於如何有效利用 DeepSeek-R1 進行文本生成和圖像處理等 AI 任務,並強調模型優化和降低運算成本的重要性,同時展望了AI模型未來的發展趨勢。

Deepseek 的 5 個有趣實驗

作者進行五個關於 DeepSeek R1 以及其他模型(Claude 3.5、OpenAI)的實驗。

實驗一測試模型生成 3D 瀏覽器模擬程式碼的能力,結果 DeepSeek R1 成功完成;

實驗二結合 Claude 的功能與 DeepSeek R1 的推理機制,實現更複雜的資訊處理;

實驗三探討模型在一個數值猜測遊戲中的推理過程,展現了模型的思考步驟;

實驗四修改經典的河渡問題,測試模型是否能跳脫既有訓練資料的限制,DeepSeek R1和Claude成功解決,OpenAI則失敗;

實驗五則以情境題測試模型的連續推理能力,多個模型皆能得出正確結論。

整體而言,影片旨在展示大型語言模型的程式碼生成、工具使用、推理能力以及突破訓練資料限制的潛力,並分享作者對模型能力的觀察與思考。

DeepSeek R1 在 Pi 達每秒 200 個 token

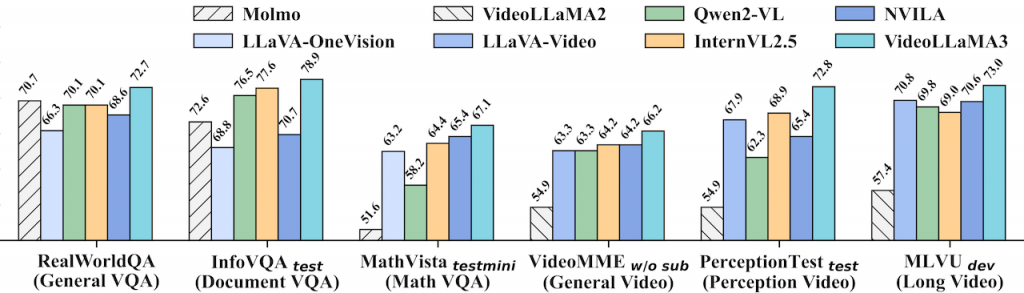

VideoLLaMA3 影片理解模型

一個以視覺為中心的多模態基礎模型,用於圖像和影片理解。其核心設計理念是優先利用高品質的圖像文字數據,而非大規模的影片文字數據進行訓練。模型採用四階段訓練流程:視覺對齊、視覺語言預訓練、多任務微調以及影片中心微調。此外,VideoLLaMA3 的架構設計能根據影像大小動態調整視覺 token 數量,並在影片處理中減少冗餘的視覺 token,以提升效率和準確性。最終,VideoLLaMA3 在圖像和影片理解基準測試中取得了令人信服的成果。(HuggingFace)

MangaNinja 優質線稿圖像上色

MangaNinja 的主要設計目標是基於協助線稿圖像上色。它採用了幾個關鍵技術:區塊隨機置換模組(patch shuffling module),點驅動控制方案(point-driven control scheme)。實驗結果顯示,MangaNinja 在色彩準確度和生成圖像質量方面明顯優於其他現有的非生成式著色方法(如 BasicPBC)、一致性生成方法(如 IP-Adapter)以及 AnyDoor。總結來說,MangaNinja 透過區塊隨機置換模組和點驅動控制方案實現精確的線稿著色。它不僅可以處理單一參考圖像,還可以利用多個參考圖像進行著色,並且可以處理參考圖像與線稿之間存在差異的情況。此外,MangaNinja 的互動式控制功能,允許使用者更精確地控制著色結果。

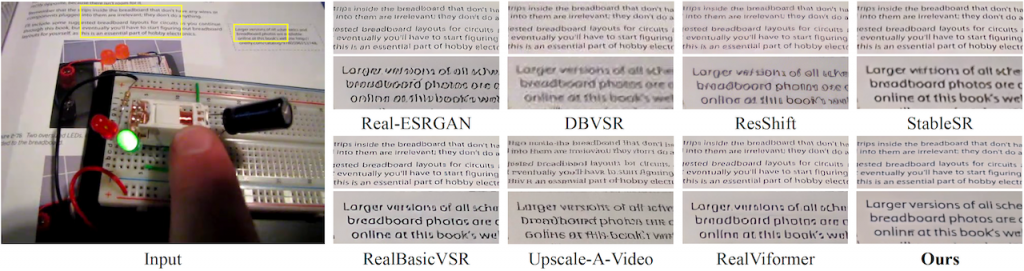

STAR 提升真實世界影片的解析度

一種名為 STAR(Spatial-Temporal Augmentation with Text-to-Video Models for Real-World Video Super-Resolution) 的新方法,用於提升真實世界影片的高解析度。STAR 的核心概念是將文字轉影片 (T2V) 模型整合到影片超解析度任務中,藉此改善時間一致性並提升影片品質。不同於以往僅使用靜態影像訓練的模型,STAR 利用 T2V 模型捕捉影片的動態特性。為了解決真實世界影片中複雜退化造成的瑕疵和 T2V 模型的高生成能力可能導致的保真度下降問題,STAR 提出了局部資訊增強模組 (LIEM) 和動態頻率 (DF) 損失函數,有效降低瑕疵並提升細節還原度和時間一致性,最終達成更逼真且高品質的影片超解析度結果。 STAR 也提供了與其他先進方法的比較,驗證了 STAR 的有效性。

在 STAR 的研究中,CogVideoX 是被引用的基準模型之一。研究人員來自:南京大學、字節跳動、西南大學。總括而言,時空增強是 STAR 系統的核心概念,它通過整合 T2V 模型,並引入 LIEM 和 DF Loss 來克服真實世界影片超解析度中的挑戰,實現更高質量的影片重建。這使得 STAR 能夠有效地處理複雜的退化,並產生具有良好時空一致性和高保真度的超解析度影片。

MiniMax-01 閃電注意力機制模型

MiniMax 公司釋出開源 MiniMax-01 系列大型語言模型,包含文字模型 MiniMax-Text-01 和視覺多模態模型MiniMax-VL-01。其核心採用了創新大規模的「Lightning Attention」機制,這是一種新型注意力機制,能有效處理長達 400 萬個 token 的超長上下文,遠超其他領先模型,同時在效能上與全球頂尖模型持平。模型的開源旨在推動 AI Agent 時代的發展,並透過高效的架構和訓練方法,提供具有競爭力的 API 服務。MiniMax 也強調了其模型在長上下文理解任務中的優異表現以及其在實際應用場景中的領先地位。

想了解更多關於這模型可參考這報告詳細闡述了模型架構、計算優化策略 (包括訓練和推論階段的並行策略和通訊計算重疊技術)、預訓練數據的構建和處理方法、以及安全性和對齊訓練等方面的工作。 實驗結果顯示 MiniMax-01 在多項基準測試中取得了領先或相當的成果,並公開釋出模型權重和 API,旨在推動大型語言模型的發展。

Google 推出 PaliGemma 2 視覺語言模型

一個強大的視覺語言模型。它基於 Gemma 2 模型,新增了視覺處理能力,並提供多種模型尺寸和解析度以供選擇,用家可根據任務需求調整。PaliGemma 2 的亮點包括更長的內容生成能力,以及在化學辨識、樂譜辨識等領域的領先表現。

PaliGemma 2 是一個強大的視覺語言模型,PaliGemma 的進階版本,主要差異在於其效能提升與功能擴展。以下列出兩者之間的主要差異:

- 擴展性:PaliGemma 2 提供多種模型尺寸(3B、10B、28B 參數)和解析度(224px、448px、896px),能針對不同任務優化效能。

- 詳細描述能力:PaliGemma 2 不僅能識別影像中的物件,更能產生詳細且符合情境的影像描述,包含動作、情緒和場景的整體敘述。

- 擴展應用領域:研究顯示,PaliGemma 2 在化學式辨識、樂譜辨識、空間推理和胸部 X 光報告生成方面表現出色。

- 易於升級:PaliGemma 2 設計為 PaliGemma 的直接替換,大多數任務都能立即獲得效能提升,且不需要大幅修改程式碼。

- 易於微調:PaliGemma 2 的彈性使其能針對特定任務和數據集進行微調,讓使用者可以根據自身需求客製化其功能。

此外,PaliGemma 2 增強了視覺能力。您可以在 Hugging Face 上找到預訓練模型和程式碼,並透過詳細的說明文件和範例筆記本將這些工具整合到您的專案中。

METAGENE-1 病原體檢測模型

METAGENE-1 是一個由南加州大學、Prime Intellect 和核酸天文台的研究人員合作開發的 70 億參數大型語言模型,它專注於分析來自廢水的 DNA 和 RNA 序列。 這個模型利用超過 1.5 兆個鹼基對的數據進行預訓練,其目標是建立一個能捕捉人類微生物組全貌的模型,以促進疫情監控、病原體檢測和新興健康威脅的早期預警。 METAGENE-1 在病原體檢測和宏基因組嵌入基準測試中取得了最先進的性能,但研究團隊也強調了在發佈更大更強大的基因組模型之前,進行嚴格的安全評估的重要性。 其開源釋出旨在促進病原體檢測和生物監控研究。

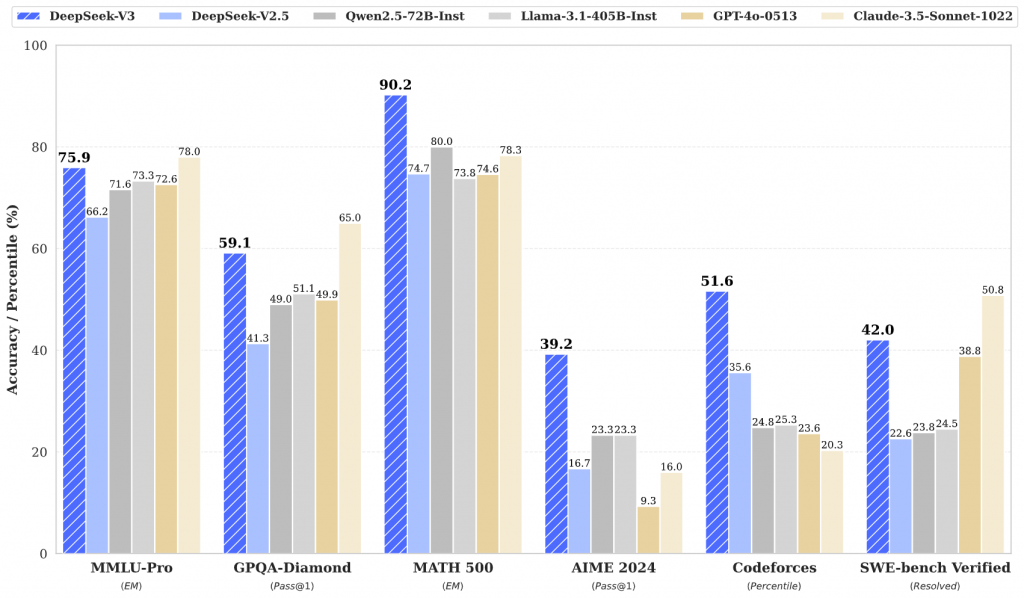

DeepSeek-V3 國產超強模型

DeepSeek-V3 的架構,包含創新的多標記預測 (MTP) 目標函數和無輔助損失的負載平衡策略,以及基於Multi-Head Latent Attention (MLA) 和 DeepSeekMoE 的高效能設計。

DeepSeek-V3 是一種強大的專家混合 (MoE) 語言模型,總參數為 671B,每個令牌啟動 37B。為了實現高效的推理和經濟高效的訓練,DeepSeek-V3 採用了多頭潛在註意力(MLA)和 DeepSeekMoE 架構,這些架構在 DeepSeek-V2 中得到了徹底的驗證。在 14.8 兆個多樣化的高品質 Token 上對 DeepSeek-V3 進行預訓練,然後進行監督微調和強化學習階段,以充分利用其能力。綜合評估表明,DeepSeek-V3 的性能優於其他開源模型,並且達到了與領先的閉源模型相當的性能。儘管性能出色,DeepSeek-V3 僅需要 2.788M H800 GPU 小時即可完成完整訓練。此外,它的訓練過程非常穩定。在整個訓練過程中,沒有遇到任何不可恢復的損失高峰或執行任何回滾。