Phantom 是字節跳動最新的影片生成框架,主要是可以生成主體一致性(Subject-to-Video)的影片 。Phantom 會嚴格保留由用家提供的參考影像特徵,同時亦會根據提供的提示詞,創造出生動同連貫的影片。這個技術不單止可以用於單一主體,亦能夠同時處理多個主體之間的互動。透過跨模態對齊的訓練方式,Phantom 確保生成的影片內容既符合文字指令,亦能夠精準呈現參考影像中的主體。

Phantom 是字節跳動最新的影片生成框架,主要是可以生成主體一致性(Subject-to-Video)的影片 。Phantom 會嚴格保留由用家提供的參考影像特徵,同時亦會根據提供的提示詞,創造出生動同連貫的影片。這個技術不單止可以用於單一主體,亦能夠同時處理多個主體之間的互動。透過跨模態對齊的訓練方式,Phantom 確保生成的影片內容既符合文字指令,亦能夠精準呈現參考影像中的主體。

影片主要探討多模態嵌入模型 (Multimodal Embedding Models) 與檢索增強生成 (Retrieval-Augmented Generation, RAG) 的應用。作者討論了 Voyage AI 的多模態嵌入模型,並強調模型能有效地將圖像與文字等多種模態的資料整合到同一的嵌入空間,由於傳統的 CLIP 模型在多模態檢索和 RAG 應用中存在模態差距等問題,而 Voyage AI 可以直接將不同模態的資料轉換為 tokens 並輸入 Transformer 編碼器,解決了這些限制。

透過 Gemini 2.0 API 和 Next.js 框架,作者分享了如何建構一個實時多模態應用程式。佢能夠接收影像和語音輸入,並透過 WebSocket 傳送至 Gemini API。Gemini API 會生成音頻輸出和文字轉錄,然後整合到有互動功能的聊天介面。教學包括深入探討應用程式的各個組件部分,例如媒體擷取、音訊處理、WebSocket 連線、轉錄服務以及用戶介面的更新。作者亦提供了開源的程式範例,並且逐步加以說明,方便大家由 GitHub 複製,並執行這應用程式。

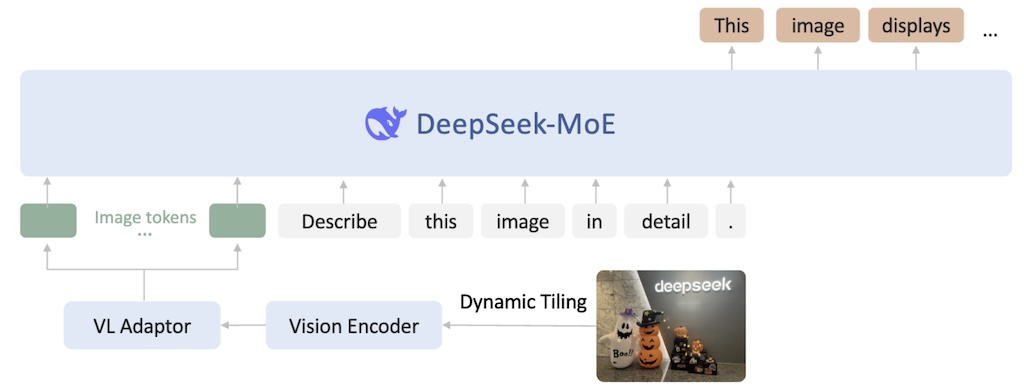

DeepSeek-VL2 使用 MoE 混合專家 Mixture-of-Experts 的視覺語言模型,主要在於提升多模態理解能力。DeepSeek-VL2 在視覺問答、光學字元識別、文件理解和視覺基礎等方面表現出色。模型包含三個版本:Tiny、Small 和 Base,並提供了模型下載、Gradio web 介面範例。

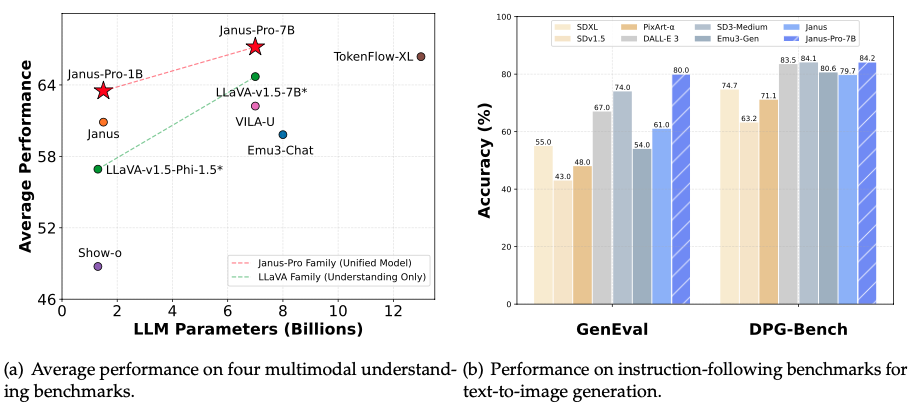

Janus 系列多模態理解和生成模型。核心是三個模型:Janus、Janus-Pro 和 JanusFlow,它們都基於單一 Transformer 架構,實現了統一的多模態理解和生成。Janus-Pro 是 Janus 的進階版,透過優化訓練策略、擴展數據和提升模型規模,顯著提升了性能。JanusFlow 則結合了自迴歸語言模型和修正流模型,在效能和多功能性上取得平衡。該資源提供了模型下載、快速入門指南,以及使用 Python 進行多模態理解和圖像生成的程式碼範例,並提供了 Hugging Face 線上演示和本地 Gradio/FastAPI 演示的說明。 最後,還列出了相關論文的引用資訊。

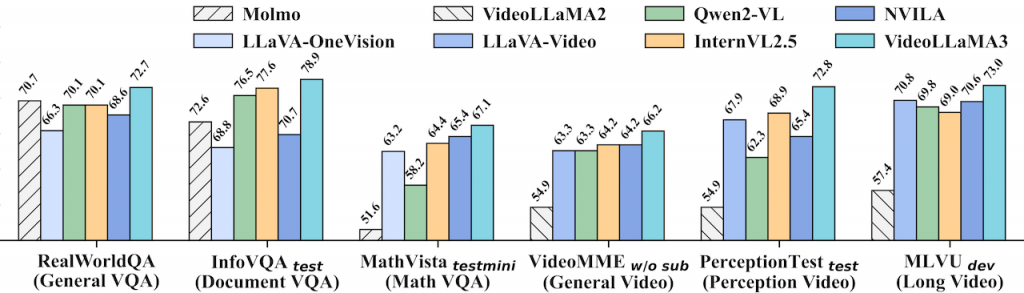

一個以視覺為中心的多模態基礎模型,用於圖像和影片理解。其核心設計理念是優先利用高品質的圖像文字數據,而非大規模的影片文字數據進行訓練。模型採用四階段訓練流程:視覺對齊、視覺語言預訓練、多任務微調以及影片中心微調。此外,VideoLLaMA3 的架構設計能根據影像大小動態調整視覺 token 數量,並在影片處理中減少冗餘的視覺 token,以提升效率和準確性。最終,VideoLLaMA3 在圖像和影片理解基準測試中取得了令人信服的成果。(HuggingFace)

谷歌最近的人工智慧計畫是模擬整個物理世界的系統,谷歌認為這是通往通用人工智慧的關鍵路徑,以及它如何與谷歌更廣泛的人工智慧策略相連,這當然包括 Gemini。

這是 Google DeepMind 一項突破性的 AI 計畫:建構模擬整個物理世界的系統,以朝向通用人工智能 (AGI) 邁進。該系統整合了多模態數據 (例如影片、音訊和機器人數據),用以模擬真實世界的物理規律,並將應用於機器人、遊戲和科學研究等領域。 這項計畫展現 Google 擴展 AI 模型以達到前所未有的智能和真實感的雄心壯志,並預期將對各產業帶來革命性的影響,加速 AGI 的實現。

MiniMax 公司釋出開源 MiniMax-01 系列大型語言模型,包含文字模型 MiniMax-Text-01 和視覺多模態模型MiniMax-VL-01。其核心採用了創新大規模的「Lightning Attention」機制,這是一種新型注意力機制,能有效處理長達 400 萬個 token 的超長上下文,遠超其他領先模型,同時在效能上與全球頂尖模型持平。模型的開源旨在推動 AI Agent 時代的發展,並透過高效的架構和訓練方法,提供具有競爭力的 API 服務。MiniMax 也強調了其模型在長上下文理解任務中的優異表現以及其在實際應用場景中的領先地位。

想了解更多關於這模型可參考這報告詳細闡述了模型架構、計算優化策略 (包括訓練和推論階段的並行策略和通訊計算重疊技術)、預訓練數據的構建和處理方法、以及安全性和對齊訓練等方面的工作。 實驗結果顯示 MiniMax-01 在多項基準測試中取得了領先或相當的成果,並公開釋出模型權重和 API,旨在推動大型語言模型的發展。

一個強大的視覺語言模型。它基於 Gemma 2 模型,新增了視覺處理能力,並提供多種模型尺寸和解析度以供選擇,用家可根據任務需求調整。PaliGemma 2 的亮點包括更長的內容生成能力,以及在化學辨識、樂譜辨識等領域的領先表現。

PaliGemma 2 是一個強大的視覺語言模型,PaliGemma 的進階版本,主要差異在於其效能提升與功能擴展。以下列出兩者之間的主要差異:

此外,PaliGemma 2 增強了視覺能力。您可以在 Hugging Face 上找到預訓練模型和程式碼,並透過詳細的說明文件和範例筆記本將這些工具整合到您的專案中。